Понимание энтропии в психических процессах, энтропия и ее противоположность, психические расстройства и энтропия, снижение психической энтропии, борьба с психической энтропией, заключение.

Cодержание

Энтропия - понятие из физики, но оно также имеет применение в контексте психологии и психотерапии. В психологии энтропия описывает степень хаоса и разрушения целостности системы - как физической, так и психической.

Понимание энтропии в психических процессах

В отношении психики, энтропия проявляется в виде постоянных отвлечений внимания, угасания функций мозга при отсутствии нагрузки и тренировки, а также возрастных когнитивных нарушений. Она может влиять на различные аспекты психической функции, от простых симптомов до более сложных состояний.

Представляя психику как многослойную структуру, можно сказать, что психическая энтропия отслаивает "слой луковицы" снаружи внутрь, от простых симптомов к более сложным состояниям. Это путь от астении к невротическим состояниям, от легких когнитивных нарушений к тяжелому слабоумию, а в случае психозов процессы энтропии протекают еще более интенсивно.

Энтропия и ее противоположность

Энтропия описывает хаос, саморазрушение и распад системы, но ей противополагается движение к упорядочиванию, к организации системы, целостности и стабильности. Это противоположие энтропии называется негэнтропией или отрицательной энтропией.

Эти два фундаментальных процесса - разрушения и созидания, хаоса и порядка - постоянно присутствуют в организме и психике человека. Психическое здоровье можно рассматривать как результат минимальной энтропии, достигаемой эффективными механизмами саморегуляции и гармоничным взаимодействием всех элементов личности, включая поведение, цели, ценности и эмоциональную сферу.

См. также

Психические расстройства и энтропия

В идеальном случае, психические нарушения возникают как следствие возрастных изменений и биологического старения организма. Однако чаще всего невротические, тревожные, депрессивные и другие расстройства являются "информационными" болезнями, сбоями в "софте" психики. В таких случаях происходит усиление энтропии системы со всеми негативными последствиями для организма и личности человека.

Поэтому очень важно стремиться к "порядку" в своей системе и управлять психической энтропией. Для этого можно оценить уровень психической энтропии в своей жизни, выявить основные факторы, вносящие "хаос и разрушение" и провести работу над ними.

Снижение психической энтропии

Существует несколько способов снижения психической энтропии и достижения более упорядоченного состояния:

- Осознание и осмысление своих внутренних конфликтов и противоречий.

- Работа над системой ассоциаций, убеждений, воспоминаний и опыта.

- Проведение самостоятельной работы, включающей анализ симптомов и сложностей, а также их информационную составляющую.

- Обращение за помощью к квалифицированному специалисту, который поможет провести более глубокую работу над снижением энтропии.

Борьба с психической энтропией может способствовать улучшению психического здоровья и повышению качества жизни. Важно стремиться к упорядоченности и гармонии внутри себя, чтобы достичь более эффективного функционирования и благополучия.

Заключение

Психическая энтропия является важным концептом в психологии и психотерапии. Понимание ее принципов и методов управления энтропией может помочь нам лучше понять себя и свои внутренние процессы. Снижение психической энтропии способствует росту и развитию, а также улучшению качества жизни в целом.

См. также

Что нам скажет Википедия?

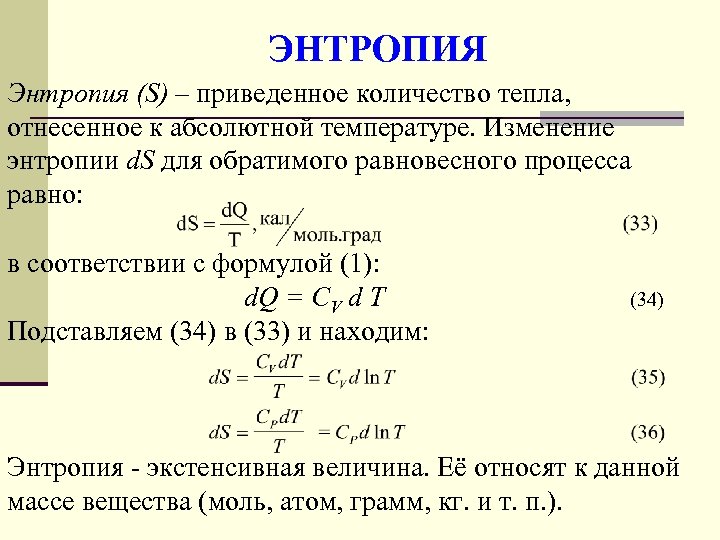

Энтропия (от др.-греч. ἐν «в» + τροπή «обращение; превращение») — широко используемый в естественных и точных науках термин, обозначающий меру необратимого рассеивания энергии или бесполезности энергии. Для понятия энтропии в данном разделе физики используют название термодинамическая энтропия; термодинамическая энтропия обычно применяется для описания равновесных (обратимых) процессов.

В статистической физике энтропия характеризует вероятность осуществления какого-либо макроскопического состояния. Кроме физики, термин широко употребляется в математике: теории информации и математической статистике. В этих областях знания энтропия определяется статистически и называется статистической или информационной энтропией. Данное определение энтропии известно также как энтропия Шеннона (в математике) и энтропия Больцмана—Гиббса (в физике).

Хотя понятия термодинамической и информационной энтропии вводятся в рамках различных формализмов, они имеют общий физический смысл — логарифм числа доступных состояний системы. В неравновесных (необратимых) процессах энтропия также служит мерой близости состояния системы к равновесному: чем больше энтропия, тем ближе система к равновесию (в состоянии термодинамического равновесия энтропия системы максимальна).

Величина, противоположная энтропии, именуется негэнтропией или, реже, экстропией.

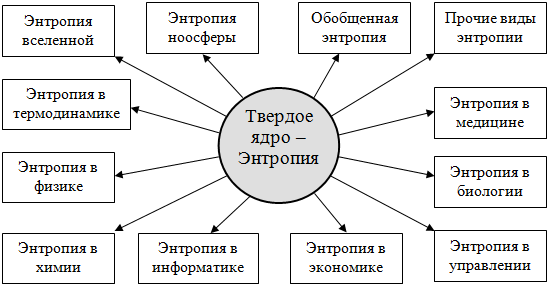

Употребление в различных дисциплинах

В термодинамике

Основная статья: Энтропия в классической термодинамике

Понятие энтропии впервые было введено Клаузиусом в термодинамике в 1865 году для определения меры необратимого рассеивания энергии, меры отклонения реального процесса от идеального.

Математически энтропия определяется как функция состояния системы, определённая с точностью до произвольного постоянного слагаемого. Разность энтропий в двух равновесных состояниях 1 и 2 по определению равна приведённому количеству тепла (δQ/T), которое надо сообщить системе, чтобы перевести её из состояния 1 в состояние 2 по любому квазистатическому пути. Так как энтропия определена с точностью до произвольной аддитивной постоянной, то можно условно принять состояние 1 за начальное и положить S1=0. Тогда

Здесь интеграл берется для произвольного квазистатического процесса. Дифференциал функции S имеет вид

Энтропия устанавливает связь между макро- и микросостояниями. Особенность данной характеристики заключается в том, что это единственная функция в физике, которая показывает направленность процессов. Поскольку энтропия является функцией состояния, то она не зависит от того, как осуществлён переход из одного состояния системы в другое, а определяется только начальным и конечным состояниями системы.

Физический смысл энтропии

Термодинамическая энтропия как физическая величина отличается своей абстрактностью, физический смысл энтропии непосредственно не вытекает из её математического выражения и не поддаётся простому интуитивному восприятию.

С физической точки зрения энтропия характеризует степень необратимости, неидеальности реального термодинамического процесса. Она является мерой диссипации (рассеивания) энергии, а также мерой оценки энергии в плане её пригодности (или эффективности) использования для превращения теплоты в работу. Два последних утверждения не относятся к необычным системам с отрицательной абсолютной температурой, в которых теплота самопроизвольно может полностью превращаться в работу.

В теории информации

Основная статья: Информационная энтропия

Для энтропии (чаще в математике) встречается также название шенноновская информация или количество информации по Шеннону.

Энтропия может интерпретироваться как мера неопределённости (неупорядоченности) или сложности некоторой системы, например, какого-либо опыта (испытания), который может иметь разные исходы, а значит, и количество информации. Таким образом, другой интерпретацией энтропии является информационная ёмкость системы. С данной интерпретацией связан тот факт, что создатель понятия энтропии в теории информации (Клод Шеннон) сначала хотел назвать эту величину информацией.

Понятие информационной энтропии применяется как в теории информации и математической статистике, так и в статистической физике (энтропия Гиббса и её упрощённый вариант — энтропия Больцмана). Математический смысл информационной энтропии — это логарифм числа доступных состояний системы. Такая функция от числа состояний обеспечивает свойство аддитивности энтропии для независимых систем. Причём, если состояния различаются по степени доступности (то есть не равновероятны), под числом состояний системы нужно понимать их эффективное количество, которое определяется следующим образом.

Пусть состояния системы равновероятны и имеют вероятность pi, тогда число состояний N=1/pi, а log N=log(1/pi). В случае разных вероятностей состояний pi рассмотрим средневзвешенную величину

где N̅ — эффективное количество состояний.

Из данной интерпретации непосредственно вытекает выражение для информационной энтропии Шеннона:

Подобная интерпретация справедлива и для энтропии Реньи, которая является одним из обобщений понятия информационная энтропия, но в этом случае иначе определяется эффективное количество состояний системы. Энтропии Реньи соответствует эффективное количество состояний, определяемое как среднее степенное взвешенное с параметром q ≤ 1 от величин 1/pi.